- genspark AI 브라우저를 드디어 윈도우를 지원합니다.

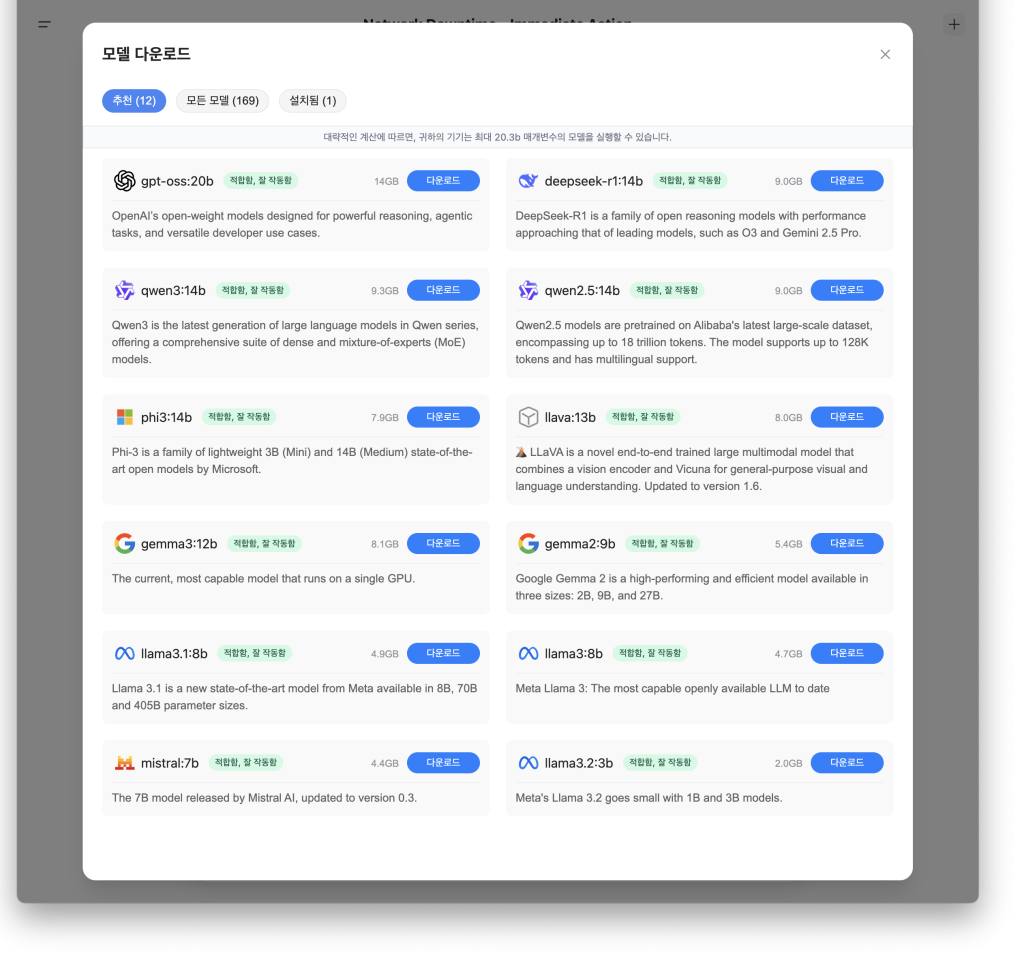

- 그와 동시에 다양한 AI 모델을 로컬에 다운로드 받아

직접 실행할 수 있는 기능이 추가 되었습니다.

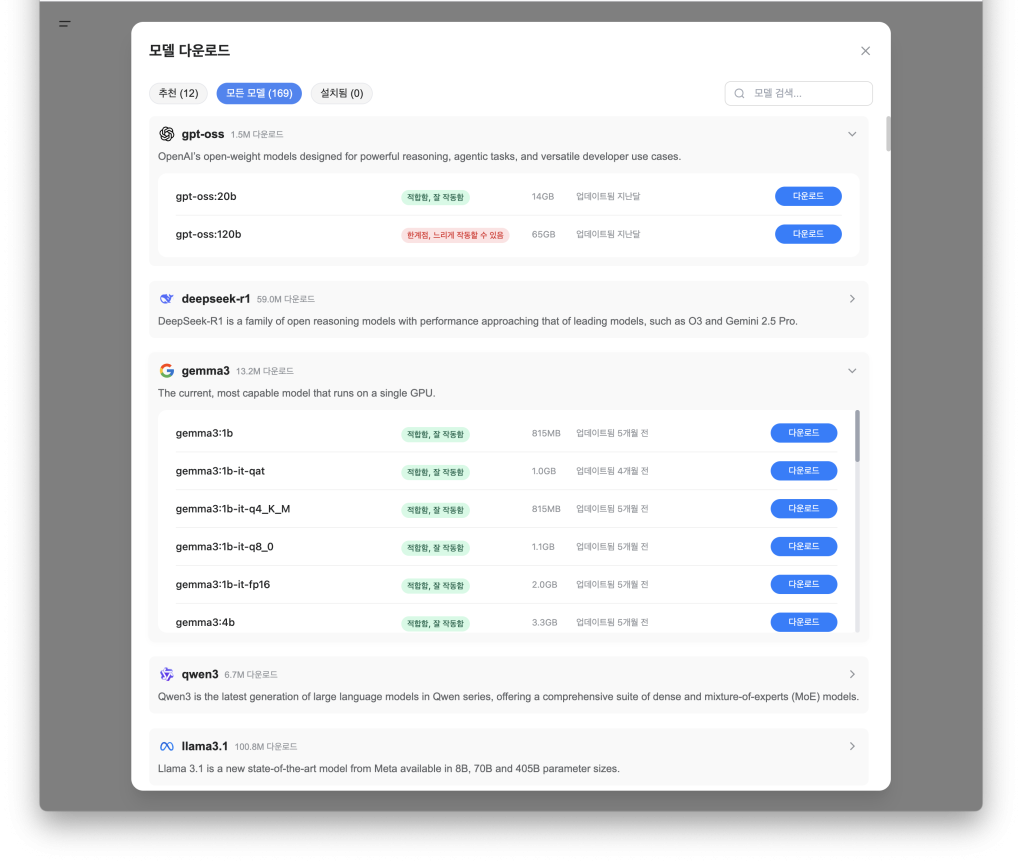

현재 지원하는 모델은 무려 169 종류입니다.

공개되어 있는 대부분의 모델을 지원합니다.

가장 많은 다운로드를 기록한 모델은 deepseek-r1 입니다.

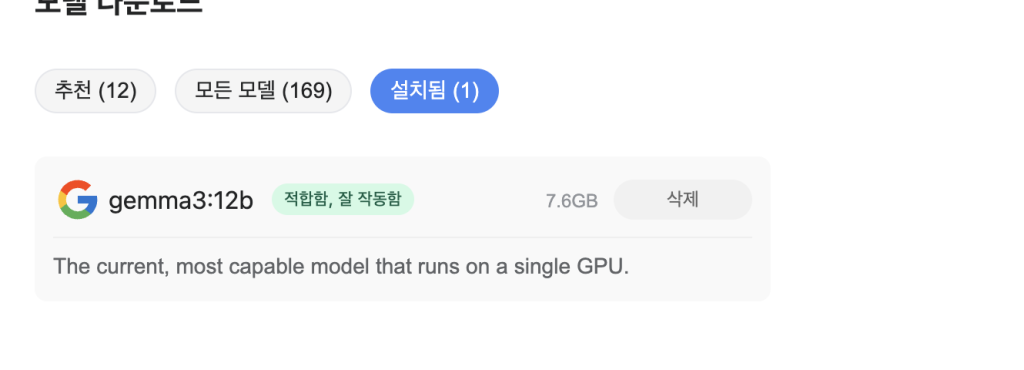

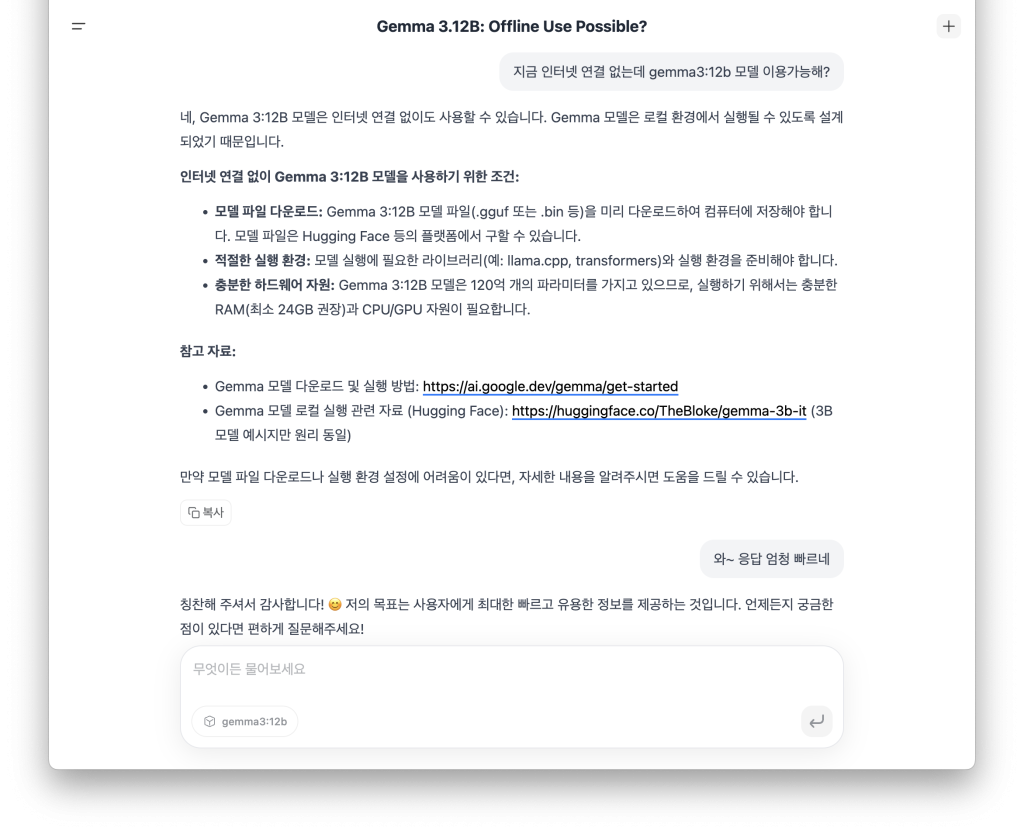

테스트를 위해 gemma3:12b (7.6GB)를

로컬로 다운받아서 돌려본 결과!

오~정말 빠르게 응답합니다.

단! CPU 온도는 급격하게 상승합니다.

메모리와 SSD가 넉넉하다면

deepseek-v3.1 (deepseek-v3.1:671b-q8_0 713GB) 모델을 돌려 보고 싶군요.

[3줄 요약]

- 번개처럼 빠른 응답

- 무료 & 인터넷 연결 없이 실행 가능

- 충분한 RAM과 SSD 필요

Genspark AI 브라우저 다운로드

https://www.genspark.ai/browser

[참고]

Genspark On-Device Free AI는 모델 전체를 RAM에 올리고 동작하는 것은 아닙니다.

작동 방식은 다음과 같습니다.

1) 모델 분할 (Model Partitioning):

모델이 너무 커서 RAM에 한 번에 올라가지 않는 경우, Genspark은 모델을 여러 부분으로 분할하여 필요할 때마다 메모리에 로드하고 사용합니다.

2) 페이징 (Paging):

모델의 일부만 RAM에 로드하고, 나머지는 저장 장치(예: SSD)에 보관합니다. 연산이 필요한 부분은 RAM으로 가져오고, 더 이상 필요 없으면 다시 저장 장치로 옮기는 방식을 사용합니다. 이를 통해 전체 모델을 RAM에 올리지 않고도 실행할 수 있습니다.

3) 하드웨어 가속 (Hardware Acceleration):

Genspark은 CPU뿐만 아니라 GPU나 특수 AI 가속기(NPU)와 같은 하드웨어 가속기를 활용하여 연산 속도를 높입니다.

따라서 Genspark On-Device Free AI는 모델 전체를 RAM에 올리는 대신, 모델의 크기와 사용 가능한 메모리, 그리고 사용 중인 하드웨어 환경에 따라 효율적으로 모델을 관리하고 실행합니다. 이를 통해 비교적 낮은 사양의 기기에서도 AI 모델을 사용할 수 있도록 지원합니다.